ОглавлениеПРЕДИСЛОВИЕРаздел I. ПРИКЛАДНАЯ СТАТИСТИКА: ЕЕ СУЩНОСТЬ И НАЗНАЧЕНИЕ (общие методические принципы) Глава 1.  1.2. Оптимизационная формулировка основных задач прикладной статистики и проблема устойчивости статистического вывода 1.2.1. Связь между оптимизационной формулировкой основных задач прикладной статистики и проблемой устойчивости статистического вывода. 1.2.2. Проблема статистического исследования зависимостей между анализируемыми показателями. 1.2.3. Проблема классификации объектов или признаков. 1.2.4. Снижение размерности исследуемого факторного пространства и отбор наиболее информативных признаков. Выводы Глаза 2. ТЕОРЕТИКО-ВЕРОЯТНОСТНЫЙ СПОСОБ РАССУЖДЕНИЯ В ПРИКЛАДНОЙ СТАТИСТИКЕ 2.1.1. Статистический ансамбль и «игра случая». 2.1.2. Теория вероятностей и условия статистического ансамбля. 2.1.3. Основные типы реальных ситуаций с позиций соблюдения условий статистического ансамбля. 2.2. «Взаимоотношения» теории вероятностей и математической статистики 2.2.2. Теоретико-вероятностный способ решения.  2.2.3. Вероятностно-статистический (или математико-статистический) способ принятия решения. ВЫВОДЫ Глава 3. МАТЕМАТИЧЕСКИЕ МОДЕЛИ В ПРИКЛАДНОЙ СТАТИСТИКЕ 3.1.1. О двух подходах к статистическому моделированию. 3.1.2. Понятие математической модели. 3.2. Общая логическая схема и основные этапы содержательного математического моделирования 3.2.2. Моделирование механизма явления вместо формальной статистической фотографии. 3.3. Понятие о статистическом моделировании 3.4. Возражения против математических моделей 3.5. Наиболее распространенные типы математических моделей, используемых в прикладной статистике 3.5.1. Модели законов распределения вероятностей случайных величин. 3.5.2. Линейные вероятностные модели. 3.5.3. Обобщение линейных моделей. 3.5.4. Геометрические модели. 3.5.5. Модели марковского типа. Выводы 4.1.1. Наблюдение, зафиксированное на объекте исследуемой совокупности (случайный эксперимент).  4.1.2. Случайные события и правила действий с ними. 4.1.3. Вероятностное пространство. Вероятности и правила действия с ними. 4.2. Непрерывное вероятностное пространство (аксиоматика А. Н. Колмогорова) 4.2.1. Специфика общего (непрерывного) случая вероятностного пространства. 4.2.2. Случайные события, их вероятности и правила действий с ними (аксиоматический подход А. Н. Колмогорова). Выводы Глава 5. случайные величины (исследуемые признаки) 5.1. Определение и примеры случайных величин 5.2. Возможные и наблюденные значения случайной величины 5.3. Типы случайных величин 5.4. Закон распределения вероятностей случайной величины. Генеральная совокупность и выборка из нее 5.4.1. Закон распределения вероятностей. 5.4.2. Генеральная совокупность и выборка из нее. 5.4.3. Основные способы организации выборки. 5.5. Способы задания закона распределения: функция распределения, функция плотности и их выборочные (эмпирические аналоги) 5.  5.1. Функция распределения вероятностей одномерной случайной величины. 5.1. Функция распределения вероятностей одномерной случайной величины.5.5.2. Функция плотности вероятности одномерной случайной величины. 5.5.3. Многомерные функции распределения и плотности. Статистическая независимость случайных величин. 5.6. Основные числовые характеристики случайных величин и их выборочные аналоги 5.6.1. Понятие о математических ожиданиях и моментах. 5.6.2. Характеристики центра группирования значений случайной величины. 5.6.3. Характеристики степени рассеяния случайной величины. 5.6.4. Вариационный ряд и порядковые статистики. 5.6.5. Квантили и процентные точки распределения. 5.6.7. Основные характеристики многомерных распределений (ковариации, корреляции, обобщенная дисперсия и др.). Выводы Глава 6. МОДЕЛИ ЗАКОНОВ РАСПРЕДЕЛЕНИЯ ВЕРОЯТНОСТЕЙ, НАИБОЛЕЕ РАСПРОСТРАНЕННЫЕ В ПРАКТИКЕ СТАТИСТИЧЕСКИХ ИССЛЕДОВАНИИ 6.1. Законы распределения, используемые для описания механизмов реальных процессов или систем 6.  1.2. Гипергеометрическое распределение. 1.2. Гипергеометрическое распределение.6.1.3. Распределение Пуассона. 6.1.4. Полиномиальное (мультиномиальное) распределение. 6.1.5. Нормальное (гауссовское) распределение. 6.1.6. Логарифмически-нормальное распределение. 6.1.7. Равномерное (прямоугольное) распределение. 6.1.8. Распределение Вейбулла и экспоненциальное (показательное). 6.1.9. Распределение Парето. 6.1.10. Распределение Коши. 6.1.11. Некоторые комбинации основных модельных распределений, используемые в прикладной статистике. 6.2. Законы распределений вероятностей, используемые при реализации техники статистических вычислений 6.2.1. «хи квадрат»-распределение. 6.2.2. Распределение Стьюдента (t-распределение). 6.2.3. F-распределение (распределение дисперсионного отношения). 6.2.4. Замечание о нецентральных «хи-квадрат» и F- и t-распределениях. 6.2.5. Г-распределение. 6.2.6. В-распределение. 6.3. Техника статистического моделирования наблюдений, подчиняющихся заданному распределению 6.  3.1. Получение равномерно распределенных на отрезке [0, 1] случайных чисел. 3.1. Получение равномерно распределенных на отрезке [0, 1] случайных чисел.6.3.2. Моделирование дискретных случайных величин. Выводы Глава 7. ОСНОВНЫЕ РЕЗУЛЬТАТЫ ТЕОРИИ ВЕРОЯТНОСТЕЙ 7.1. Неравенство Чебышева 7.2. Свойство статистической устойчивости выборочных характеристик: закон больших чисел и его следствия 7.2.1. Закон больших чисел. 7.2.2. Теорема Я. Бернулли. 7.3. Особая роль нормального распределения: центральная предельная теорема 7.3.1. Центральная предельная теорема. 7.3.2. Многомерная центральная предельная теорема. 7.4. Закон распределения вероятностей случайных признаков, являющихся функциями от известных случайных величин Выводы Раздел III. ОСНОВЫ МАТЕМАТИЧЕСКОЙ СТАТИСТИКИ Глава 8. СТАТИЧЕСКОЕ ОЦЕНИВАНИЕ ПАРАМЕТРОВ 8.1. Начальные сведения о задаче статистического оценивания параметров 8.1.2. Статистики, статистические оценки, их основные свойства.  8.1.3. Состоятельность. 8.1.4. Несмещенность. 8.1.5. Эффективность. 8.2. Функция правдоподобия. Количество информации, содержащееся в n независимых наблюдениях относительно неизвестного значения параметра 8.3. Неравенство Рао—Крамера—Фреше и измерение эффективности оценок 8.4. Асимптотические свойства оценок 8.5. Понятие об интервальном оценивании. Построение доверительных областей 8.6. Методы статистического оценивания неизвестных параметров 8.6.1. Метод максимального (наибольшего) правдоподобия. 8.6.2. Метод моментов. 8.6.3. Метод наименьших квадратов. 8.6.4. Оценивание с помощью «взвешенных» статистик; цензурирование, урезание выборок и порядковые статистики как частный случай взвешивания. 8.6.5. Построение интервальных оценок (доверительных областей). 8.6.6. Байесовский подход к статистическому оцениванию. Выводы Глава 9. СТАТИСТИЧЕСКАЯ ПРОВЕРКА ГИПОТЕЗ (статистические критерии) 9.1. Основные типы гипотез, проверяемых в ходе статистической обработки данных 9.  1.1. Гипотезы о типе закона распределения исследуемой случайной величины. 1.1. Гипотезы о типе закона распределения исследуемой случайной величины.9.1.2. Гипотезы об однородности двух или нескольких обрабатываемых выборок или некоторых характеристик анализируемых совокупностей. 9.1.4. Гипотезы о типе зависимости между компонентами исследуемого многомерного признака. 9.1.5. Гипотезы независимости и стационарности обрабатываемого ряда наблюдений. 9.2. Общая логическая схема статистического критерия 9.3. Построение статистического критерия; принцип отношения правдоподобия 9.3.1. Сущность принципа отношения правдоподобия. 9.3.2. Проверка простой гипотезы с помощью критерия логарифма отношения правдоподобия. 9.3.3. Проверка сложной гипотезы. 9.4. Характеристики «качества» статистического критерия 9.5. Последовательная схема принятия решения (последовательные критерии) 9.5.1. Последовательная схема наблюдений. 9.5.2. Последовательный критерий отношения правдоподобия (критерий Вальда) и его свойства.  9.5.3. Различение сложных гипотез в схеме обобщенного последовательного критерия. Выводы Раздел IV. ПЕРВИЧНАЯ СТАТИСТИЧЕСКАЯ ОБРАБОТКА ДАННЫХ 10.1. Документирование исследования; организация ввода и хранения данных в ЭВМ; просмотр данных 10.1.2. Ввод и хранение данных. 10.1.3. Просмотр данных. 10.2. Шкалы измерений 10.3. Изучение эмпирических распределений 10.3.1. Гистограмма. 10.3.2. Непараметрические оценки плотности. 10.3.3. Оценки функции распределения. 10.3.4. Преобразование переменных. 10.3.5. Таблицы сопряженности. 10.4. Оценивание параметров сдвига и масштаба 10.4.2. Оценивание параметров нормального закона. 10.4.3. Графический метод оценивания. 10.4.4. Проблема устойчивости оценок при небольших отклонениях распределения от нормального. 10.4.5. Оценивание положения центра симметричных распределений. 10.4.6. Параметризация с помощью экспоненциально взвешенных оценок (ЭВ-оценки). 10.  5.2. Главные компоненты. 5.2. Главные компоненты.10.5.3. Свойства наименьшего искажения геометрической структуры для главных компонент. 10.5.4, Нелинейные отображения в пространство малой размерности. 10.5.5. Многомерное метрическое шкалирование. Выводы Глава 11. ПРЕДВАРИТЕЛЬНЫЙ АНАЛИЗ ПРИРОДЫ ДАННЫХ 11.1. Проверка соответствия выбранной модели распределения исходным данным (критерии согласия) 11.1.1. Критерий «хи-квадрат» Пирсона. 11.1.2. Проверка нормального характера распределения по асимметрии, эксцессу и средним отклонениям. 11.1.3. Критерий Колмогорова — Смирнова и его применение к построению доверительных границ для неизвестной функции распределения. 11.1.4. Критерий Крамера — Мизеса — Смирнова. 11.1.5. Модификация статистик критериев Колмогорова — Смирнова и для выборок небольшого объема. 11.1.6. Статистическая техника практической реализации непараметрических критериев согласия. ll.1.7. Использование критериев согласия Колмогорова и «w-квадрат» в случае неизвестных параметров для проверки гипотезы о нормальном характере распределения.  11.2. Проверка гипотез однородности и симметрии распределения 11.2.1. Критерии однородности, основанные на эмпирических функциях распределения. 11.2.2. Критерий однородности «хи-квадрат» 11.2.3. Ранговые критерии однородности. 11.2.4. Непараметрическая проверка гипотезы равенства дисперсий. 11.2.5. Ранговые критерии для случая k > 2 классов. 11.2.6. Критерии проверки симметрии распределений. 11.2.7. Обработка совпадений. 11.2.8. Критерии однородности нормальных совокупностей (одномерный случай). 11.2.9. Критерии однородности многомерных нормальных совокупностей. 11.3. Проверка независимости и стационарности ряда наблюдений 11.3.1. Критерий серий, основанный на медиане выборки. 11.3.2. Критерий «восходящих» и «нисходящих» серий. 11.3.3. Критерий квадратов последовательных разностей (критерий Аббе). 11.4. Методы статистической обработки при наличии «стертых» (пропущенных) наблюдений 11.4.1. Оценивание неизвестных параметров при наличии пропущенных данных.  11.4.2. Использование главных компонент. 11.4.3. Заполнение «пропусков» и оценивание параметров с помощью метода максимального правдоподобия. Оценки «неподвижной точки». 11.4.4. Непараметрический подход к оценке пропусков в матрице данных. 11.5. Анализ резко выделяющихся наблюдений 11.5.2 Графические методы. 11.5.3. Аналитический метод исключения одного экстремального наблюдения. 11.5.4. Аналитический критерий одновременного исключения нескольких экстремальных наблюдений. Выводы Глава 12. ПРОГРАММНОЕ ОБЕСПЕЧЕНИЕ ПРИКЛАДНОЙ СТАТИСТИКИ И НЕКОТОРЫЕ ВОПРОСЫ ТЕХНИКИ ВЫЧИСЛЕНИЙ 12.1. Программное обеспечение прикладной статистики 12.1.1. Организация пакетов программ. 12.1.2. Вопросы организации возможности ведения данных. 12.1.3. Средства предварительной обработки (манипуляции) данных. 12.1.4. Возможности обработки данных при наличии пропущенных значений. 12.1.5. Первичная обработка неколичественных данных. 12.1.6. Средства визуализации данных.  12.1.7. Оценивание параметров и выделение аномальных наблюдений. 12.2. Вычисление функций распределения и обратных к ним 12.2.1. Нормальное распределение. 12.2.2. Распределение «хи-квадрат». 12.2.3. Бета-распределение. 12.2.4. F-распределение. 12.2.5. t-распределение Стьюдента. 12.2.6. Нецентральные распределения. 12.2.7. Аппроксимация «хвостов» распределений типа «w-квадрат» 12.2.8. Многомерное нормальное распределение. 12.2.9. Дискретные распределения. 12.2.10. Вычисление математического ожидания порядковых статистик. Выводы ИСПОЛЬЗУЕМЫЕ В КНИГЕ ОБОЗНАЧЕНИЯ СПИСОК ИСПОЛЬЗОВАННОЙ ЛИТЕРАТУРЫ |

Статистика — Колмогоров Смирнов Тест

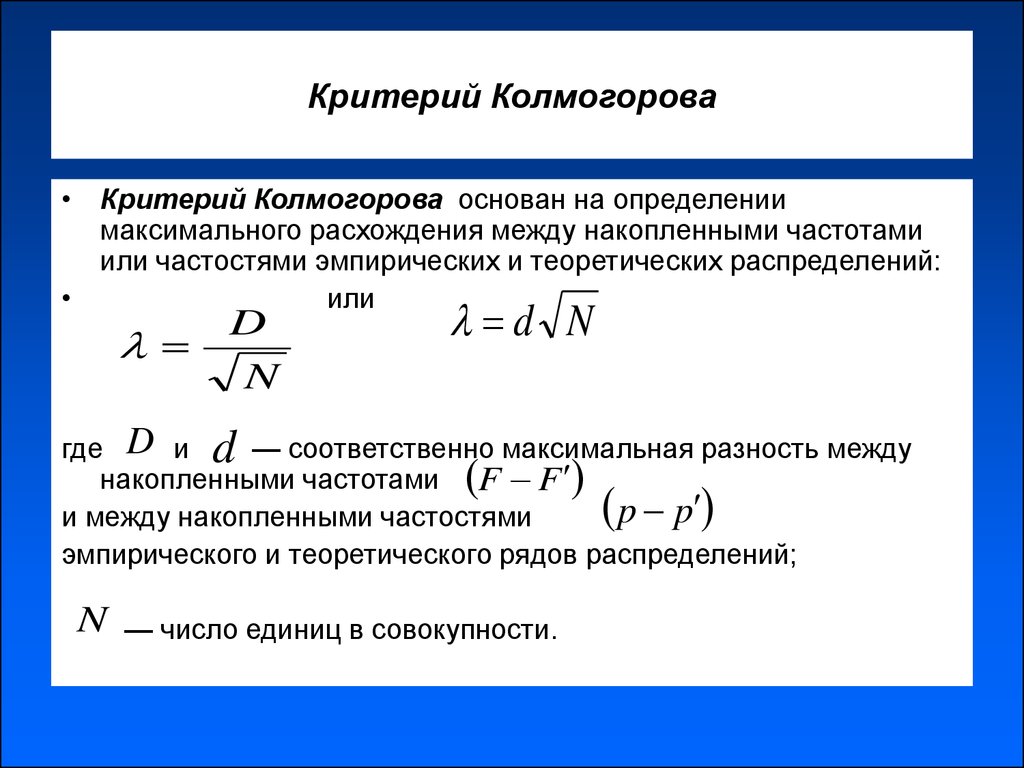

Этот тест используется в ситуациях, когда необходимо провести сравнение между наблюдаемым распределением образца и теоретическим распределением.

KS Один образец теста

Этот тест используется в качестве теста на пригодность и идеален, когда размер образца невелик. Он сравнивает накопительную функцию распределения для переменной с заданным распределением. Нулевая гипотеза предполагает отсутствие разницы между наблюдаемым и теоретическим распределением, а значение тестовой статистики «D» рассчитывается как:

Он сравнивает накопительную функцию распределения для переменной с заданным распределением. Нулевая гипотеза предполагает отсутствие разницы между наблюдаемым и теоретическим распределением, а значение тестовой статистики «D» рассчитывается как:

формула

D=максимум|Fo(X)−Fr(X)|

D=максимум|Fo(X)−Fr(X)|

Где –

Fo(X) = Наблюдаемое кумулятивное распределение частот случайной выборки из n наблюдений.

и Fo(X)= frackn = (количество наблюдений ≤ X) / (общее количество наблюдений).

Fr(X) = Теоретическое распределение частот.

Fo(X) = Наблюдаемое кумулятивное распределение частот случайной выборки из n наблюдений.

и Fo(X)= frackn = (количество наблюдений ≤ X) / (общее количество наблюдений).

Fr(X) = Теоретическое распределение частот.

Критическое значение D определяется из значений таблицы KS для одного образца теста.

Критерии приемки: если расчетное значение меньше критического, принимайте нулевую гипотезу.

Критерии отклонения: Если вычисленное значение больше, чем табличное значение, отклоните нулевую гипотезу.

пример

Постановка задачи:

В исследовании, проведенном из различных потоков колледжа, было опрошено 60 студентов с равным числом студентов из каждого потока, и было отмечено их намерение присоединиться к Драматическому клубу колледжа.

| B.Sc. | BA | B.Com | Массачусетс | M.Com | |

|---|---|---|---|---|---|

| № в каждом классе | 5 | 9 | 11 | 16 | 19 |

Ожидалось, что 12 учеников из каждого класса присоединятся к Драматическому клубу. Использование теста KS, чтобы определить, есть ли какая-либо разница между классами учащихся в отношении их намерения вступить в Драматический клуб.

Решение:

Ho: нет разницы между студентами разных потоков в отношении их намерения вступить в драматический клуб.

Мы разрабатываем кумулятивные частоты для наблюдаемого и теоретического распределения.

| Streams | Количество студентов, заинтересованных в присоединении | FO(Х) | FT(Х) | |FO(X)−FT(X)| | |

|---|---|---|---|---|---|

| Наблюдаемый (O) | теоретический (Т) | ||||

| B.Sc. | 5 | 12 | 5/60 | 12/60 | 7/60 |

| BA | 9 | 12 | 14/60 | 24/60 | 10/60 |

| B.COM. | 11 | 12 | 25/60 | 36/60 | 11/60 |

| Массачусетс | 16 | 12 | 41/60 | 48/60 | 7/60 |

| M.COM. | 19 | 12 | 60/40 | 60/60 | 60/60 |

| Всего | п = 60 | ||||

Тестовая статистика |D| рассчитывается как:

D=Максимум|F0(X)−FT(X)|[7pt]= frac1160[7pt]=0,183

Табличное значение D на уровне значимости 5% определяется как

D0. 05= frac1.36 sqrtn[7pt]= frac1.36 sqrt60[7pt]=0.175

05= frac1.36 sqrtn[7pt]= frac1.36 sqrt60[7pt]=0.175

Поскольку рассчитанное значение больше критического, следовательно, мы отвергаем нулевую гипотезу и заключаем, что существует разница между учащимися разных потоков в их намерении вступить в Клуб.

KS Два образца теста

Если вместо одной существует две независимые выборки, тогда можно использовать тест KS для двух выборок, чтобы проверить соответствие между двумя совокупными распределениями. Нулевая гипотеза утверждает, что нет разницы между двумя распределениями. D-статистика рассчитывается так же, как и KS One Sample Test.

формула

D=Максимум|Fn1(X)−Fn2(X)|

D=Максимум|Fn1(X)−Fn2(X)|

Где –

n1 = Наблюдения из первого образца.

n2 = Наблюдения из второго образца.

Было видно, что когда совокупные распределения показывают большое максимальное отклонение |D|, это указывает на разницу между двумя выборочными распределениями.

Критическое значение D для выборок, где n1=n2 и составляет ≤ 40, используется таблица KS для двух выборок. Когда n1 и / или n2> 40, следует использовать таблицу KS для больших выборок из двух выборочных тестов. Нулевая гипотеза принимается, если вычисленное значение меньше, чем табличное значение, и наоборот.

Когда n1 и / или n2> 40, следует использовать таблицу KS для больших выборок из двух выборочных тестов. Нулевая гипотеза принимается, если вычисленное значение меньше, чем табличное значение, и наоборот.

Таким образом, использование любого из этих непараметрических тестов помогает исследователю проверить значимость его результатов, когда характеристики целевой группы населения неизвестны или не было сделано никаких предположений о них.

Когда и где его использовать

Что такое тест Колмогорова-Смирнова (тест KS или тест KS)?

Тест Колмогорова-Смирнова (тест KS или тест KS) используется для сравнения двух дистрибутивов, чтобы определить, берутся ли они из одного и того же базового дистрибутива.

В типичном случае использования машинного обучения есть два дистрибутива (A и B), которые вы пытаетесь сравнить. Одно распределение A может быть такой функцией, как баланс счета, в наборе данных для обучения модели. Другая раздача B может быть той же характеристикой, балансом счета, но агрегированной в производственном временном окне (обычно ежедневно или ежечасно). Как разработчик модели, вы хотите знать, используется ли развернутая модель для распределения данных, отличного от обучающего набора данных. Критерий Колмогорова-Смирнова (КС) — это непараметрический статистический критерий, который можно использовать для сравнения A и B , чтобы увидеть, отличаются ли они.

Как разработчик модели, вы хотите знать, используется ли развернутая модель для распределения данных, отличного от обучающего набора данных. Критерий Колмогорова-Смирнова (КС) — это непараметрический статистический критерий, который можно использовать для сравнения A и B , чтобы увидеть, отличаются ли они.

В отличие от других показателей, которые позволяют сравнивать распределения, такие как JS-расхождение, PSI и KL-расхождение, основанные на теории информации математика Клода Шеннона, тест K-S основан на статистике. это непараметрический , что означает, что он работает со всеми типами распределений. Таким образом, его использование не ограничивается известными распределениями, такими как нормальное или биномиальное — ваши данные могут принимать любую форму, и тест К-С по-прежнему работает. Стоит отметить, что статистика теста KS также не является метрикой в формальном смысле, поскольку она не удовлетворяет неравенству треугольника.

В производственных приложениях машинного обучения функции могут быть распределениями всех типов, поэтому для анализа требуется использование непараметрической статистики. Статистика KS ограничена в своих приложениях числовыми переменными, такими как числа с плавающей запятой или целыми числами, и не работает для дискретных категориальных признаков.

Статистика KS ограничена в своих приложениях числовыми переменными, такими как числа с плавающей запятой или целыми числами, и не работает для дискретных категориальных признаков.

Целью теста KS является определение того, различаются ли два распределения A и B . Статистика теста KS дает числовое значение, связанное с этой разницей. Статистика теста KS определяется как максимальное значение разницы между кумулятивными функциями распределения (CDF) A и B. В настройках машинного обучения CDF обычно выводятся эмпирическим путем из выборок наборов данных и называются eCDF.

Данные, которые вы собираете для переменной или функции при обучении или производстве, могут выглядеть так, как показано выше. Эмпирический CDF создается путем упорядочения данных по значению и создания кусочного графика.

Вот простой код Python для CDF:

CDF создает пошаговую кумулятивную сумму по диапазону переменной данных.

В приведенном выше примере можно увидеть eCDF баланса учетной записи объекта из рабочей среды по сравнению с eCDF баланса учетной записи из обучения. Синяя кусочная eCDF — это обучающие данные, а черная линия — производственные данные. Красная стрелка представляет статистику теста KS, максимальную разницу между eCDF.

Синяя кусочная eCDF — это обучающие данные, а черная линия — производственные данные. Красная стрелка представляет статистику теста KS, максимальную разницу между eCDF.

В чем разница между тестом KS с одним образцом и тестом KS с двумя образцами?

Существует две версии теста KS: одновыборочная и двухвыборочная (не путать с односторонней и двусторонней). Приведенные выше примеры представляют собой тест KS с двумя выборками, где оба распределения являются эмпирическими и получены из реальных данных.

- Две выборки: eCDF A по сравнению с eCDF B

- Один образец: eCDF для A по сравнению с CDF для B

Одновыборочный тест KS почти никогда не используется в производственном машинном обучении. Одновыборочный тест K-S используется, когда вы сравниваете одиночную эмпирическую выборку с теоретическим параметризованным распределением. Примером этого может быть проверка того, является ли сумма баланса счета в обучении (распределение A) нормально распределенной (распределение B).

Распределение Колмогорова и качество подгонки

Статистика теста KS, представляющая собой значение, полученное путем измерения максимальной разницы двух eCDF, представляет собой только одну выборку. Распределение Колмогорова — это распределение статистики теста К-С, если вы взяли большое количество выборок из одного и того же распределения.

Для создания дистрибутива Колмогорова:

- Вы можете загрузить свои данные или собрать другой eCDF

- Запустите 500 раз, чтобы сгенерировать 500 eCDF

- Рассчитать K-S для каждого eCDF

- Постройте график всех 500 значений K-S в виде распределения

500 выборок статистики теста K-S

Выше показано, как будет выглядеть распределение K-S при размере выборки N. Каждая взятая вами выборка будет иметь разное значение K-S.

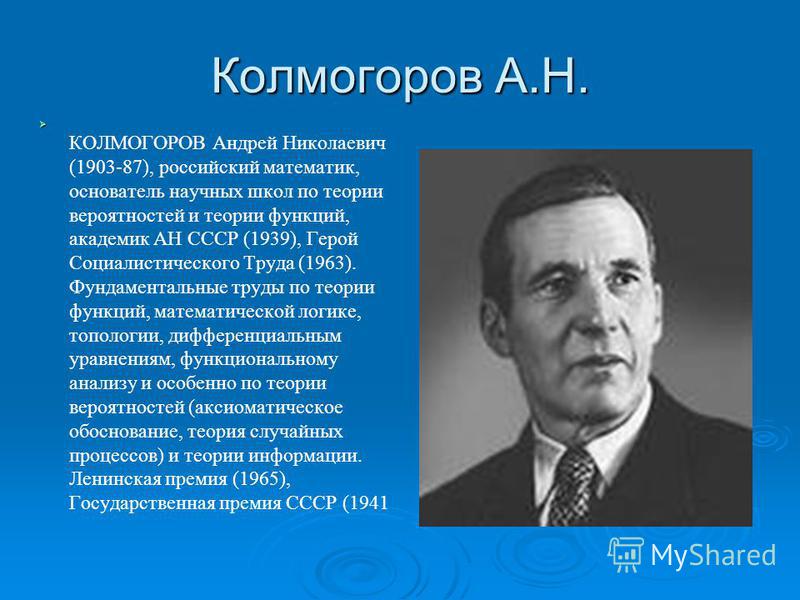

Андрей Колмогоров отмечает в своей оригинальной статье на эту тему, что распределение значений K-S из нескольких выборок принимает определенную форму, которая теперь называется распределением Колмогорова.

Это распределение имеет уравнение в закрытой форме, которое зависит только от количества выборок, использованных при создании eCDF. Распределение Колмогорова отличается от распределения Гаусса, но вы все равно можете применять некоторые из тех же концепций p-значения. Значение p, возвращаемое в python «ks_2samp», просто смотрит на это распределение на основе количества выборок и измеренной статистики теста KS. Код определяет вероятность выборки статистического значения теста K-S, предполагая, что K-S распределен как распределение Колмогорова. Это проверка на пригодность. Для получения дополнительной информации, StatsExchange предлагает подробное техническое исследование этой темы.

Чтобы сделать это более конкретным, вы можете запустить пару примеров ниже (код):

Если вам интересно узнать больше, вот отличный обзорный видеоролик на эту тему.

Как контролировать тест KS с течением времени?

В типичном учебнике по статистике критерий K-S представляет собой статическое сравнение двух распределений A и B . В случае использования мониторинга мы периодически генерируем eCDF, периодически измеряя K-S. Мы отслеживаем статистику теста KS с течением времени как показатель того, что распределение изменилось. K-S и критерий согласия используются в качестве теста для каждого образца для установления порога предупреждения.

В случае использования мониторинга мы периодически генерируем eCDF, периодически измеряя K-S. Мы отслеживаем статистику теста KS с течением времени как показатель того, что распределение изменилось. K-S и критерий согласия используются в качестве теста для каждого образца для установления порога предупреждения.

На приведенной выше диаграмме показано активное использование K-S в мониторинге моделей объектов, когда ежедневно выполняется тест компонента, чтобы убедиться, что он находится в пределах распространения.

Стоит отметить, что запустить это на практике в большой операционной среде машинного обучения не так просто, как ежедневно проводить тест на соответствие в работе. Когда появляется предупреждение о том, что работа только начинается, быстрое определение того, что изменилось и как это связано с данными, имеет решающее значение для управления десятками или тысячами моделей и более чем 100 функциями.

Когда следует использовать KS по сравнению с PSI, расхождением KL и расхождением JS?

Существует много различий между метриками сравнения распределения на основе теории информации и K-S. Одна интуиция, о которой полезно подумать, заключается в том, что информационное содержание может меняться между двумя распределениями, но статистика теста KS может не измениться. eCDF над любым произвольным порядком точек после максимума не изменяет статистику теста KS (если они не создают максимум). Это было бы похоже на перераспределение данных в верхних ячейках распределения. В метриках, основанных на теории информации, любое перемещение данных между бинами фиксируется в изменении метрики.

Одна интуиция, о которой полезно подумать, заключается в том, что информационное содержание может меняться между двумя распределениями, но статистика теста KS может не измениться. eCDF над любым произвольным порядком точек после максимума не изменяет статистику теста KS (если они не создают максимум). Это было бы похоже на перераспределение данных в верхних ячейках распределения. В метриках, основанных на теории информации, любое перемещение данных между бинами фиксируется в изменении метрики.

Заключение

Критерий K-S — отличный статистический тест для наблюдения за распределениями, сравнения распределений и сравнения степени соответствия между распределениями. Аризе также обнаружил, что меры типа теории информации Шеннона — расхождение JS, расхождение PSI и KL — на практике немного более гибки для разных типов объектов. Для получения дополнительной информации ознакомьтесь с этим ресурсом по тесту KS и оригинальным исследовательским документом по этой теме.

Тест Колмогорова-Смирнова (KS Test) — GeeksforGeeks

В этой статье мы рассмотрим непараметрический тест, который можно использовать для определения того, одинакова ли форма двух распределений или нет.

Что такое тест Колмогорова-Смирнова?

Тест Колмогорова-Смирнова — очень эффективный способ определить, существенно ли отличаются два образца друг от друга. Обычно используется для проверки однородности случайных чисел. Однородность является одним из наиболее важных свойств любого генератора случайных чисел, и для его проверки можно использовать критерий Колмогорова-Смирнова. Тест Колмогорова-Смирнова также можно использовать для проверки того, различаются ли два основных одномерных распределения вероятностей. Это очень эффективный способ определить, существенно ли отличаются два образца друг от друга. Статистика Колмогорова-Смирнова количественно определяет расстояние между эмпирической функцией распределения выборки и кумулятивной функцией распределения эталонного распределения или между эмпирическими функциями распределения двух выборок.

Как работает тест Колмогорова-Смирнова?

Прежде чем ответить на этот вопрос, нам нужно обсудить цель использования этого теста. Основная идея использования этого теста состоит в том, чтобы проверить, следуют ли две выборки, с которыми мы имеем дело, одному и тому же типу распределения или форма распределения одинакова или нет.

Основная идея использования этого теста состоит в том, чтобы проверить, следуют ли две выборки, с которыми мы имеем дело, одному и тому же типу распределения или форма распределения одинакова или нет.

Прежде всего, если предположить, что форма или распределение вероятностей двух выборок одинаковы, то максимальное значение абсолютной разницы между кумулятивной разностью распределения вероятностей между двумя функциями будет одинаковым. И выше значение разница между формой распределения высока.

Для проверки формы выборки данных обычно использовали проверку гипотез двух типов:

- Параметрический тест

- Непараметрический тест

Нулевая гипотеза теста Колмогорова-Смирнова

4 H 04 (Нулевая гипотеза): Нулевая гипотеза предполагает, что две выборки имеющихся данных взяты из одного и того же распределения.

Поскольку тест KS является непараметрическим методом, нет ограничений, что выборки должны быть из нормального распределения, для которого мы используем распределение хи-квадрат.

-> Расположите N случайных чисел в порядке возрастания.

-> Рассчитать D+ как max(i/N-Ri) для всех i в (1, N)

-> Рассчитать D- как max(Ri-((i-1)/N)) для всех i в (1, N)

-> Рассчитать D как max(sqrt(N) * D+, sqrt(N) * D-)

-> Если D>D(альфа)

Отвергает единообразие

еще

Он не может отвергнуть нулевую гипотезу. Ниже приведена реализация вышеуказанного алгоритма на Python:

Python3

5_max 5 |

Выход:

11,691053208016287

С какой целью используется критерий Колмогорова – Смирнова?

Бывают случаи, когда мы хотели бы проверить, соответствует ли конкретная выборка нормальному распределению или нет. Что касается применения других статистических методов для анализа выборки, для которых необходимым условием является то, что она должна подчиняться нормальному распределению. Для этого мы используем одновыборочный критерий Колмогорова-Смирнова.

Но этот тест также можно использовать, чтобы определить, соответствуют ли две имеющиеся у нас выборки одному и тому же распределению или нет.

Ограничения теста Колмогорова-Смирнова

- Применяется только к непрерывным распределениям.

append(x)

append(x)  append(y)

append(y)